Procyon® AI Inference Benchmark für Android

Benchmark AI-Leistung und -Qualität mit NNAPI

Maschinelles Lernen bietet aufregende neue Funktionen in mobilen Apps. Viele Geräte verfügen jetzt über dedizierte Hardware, um die rechenintensiven Vorgänge zu beschleunigen, die für die Inferenz auf dem Gerät erforderlich sind. Die Android Neural Networks API (NNAPI) bietet eine Basisschicht für Frameworks des maschinellen Lernens, um auf die dedizierte AI-Verarbeitungshardware in einem Gerät zuzugreifen.

Der Procyon AI Inference Benchmark für Android misst die KI-Leistung von Android-Geräten, die NNAPI verwenden. Der Benchmark-Score spiegelt sowohl die Geschwindigkeit als auch die Genauigkeit der Inferenzoperationen auf dem Gerät wider. Mit dem Procyon AI Inference Benchmark für Android können Sie nicht nur die Leistung von dedizierter KI-Verarbeitungshardware in Android-Geräten messen, sondern auch die Qualität der NNAPI-Implementierung überprüfen.

Der Benchmark verwendet eine Reihe gängiger neuronaler Netze auf dem neuesten Stand der Technik, die auf dem Gerät ausgeführt werden, um allgemeine Aufgaben des maschinellen Sehens auszuführen. Der Benchmark wird auf der dedizierten AI-Verarbeitungshardware des Geräts über NNAPI ausgeführt. Der Benchmark führt jeden Test zum Vergleich auch direkt auf der GPU und / oder der CPU aus.

Merkmale

- Tests basierend auf gängigen Aufgaben des maschinellen Sehens unter Verwendung modernster neuronaler Netze.

- Misst sowohl die Inferenzleistung als auch die Ausgabequalität.

- Vergleichen Sie die Leistung von NNAPI, CPU und GPU.

- Überprüfen Sie die NNAPI-Implementierung und -Kompatibilität.

- Optimierung der Treiber für Hardwarebeschleuniger.

- Vergleichen Sie die für Float und Integer optimierte Modellleistung.

- Einfache Einrichtung und Verwendung auf eine Gerät oder über ADB.

NNAPI Leistung und Qualität

Mit dem Procyon AI Inference Benchmark für Android können Sie die Leistung dedizierter KI-Verarbeitungs-Hardware messen und die Qualität der NNAPI-Implementierung mit Tests auf der Grundlage gängiger Machine-Vision-Aufgaben überprüfen.

Entwickelt für Profis

Wir haben den Procyon AI Inference Benchmark für Android für Ingenieurteams entwickelt, die unabhängige, standardisierte Tools zur Bewertung der allgemeinen KI-Leistung von NNAPI-Implementierungen und dedizierter mobiler Hardware benötigen.

Schnell und einfach zu bedienen

Der Benchmark ist einfach zu installieren und auszuführen - keine komplizierte Konfiguration erforderlich. Führen Sie den Benchmark auf dem Gerät oder über ADB aus, Zeigen Sie Benchmark-Ergebnisse, Diagramme und Rankings in der App an oder exportieren Sie detaillierte Ergebnisdateien zur weiteren Analyse.

Entwickelt mit Branchenexpertise

Procyon Benchmarks sind für den Einsatz in Industrie, Unternehmen und Presse konzipiert, mit Tests und Funktionen, die speziell für professionelle Anwender erstellt wurden. AI Inference Benchmark für Android wurde zusammen mit Industriepartnern im Rahmen des UL Benchmark Development Program (BDP) konzipiert und entwickelt. Das BDP ist eine Initiative von UL Solutions, die zum Ziel hat, durch enge Zusammenarbeit mit den Programm-Mitgliedern relevante und unparteiische Benchmarks zu schaffen.

Neurale Netzwerk Modelle

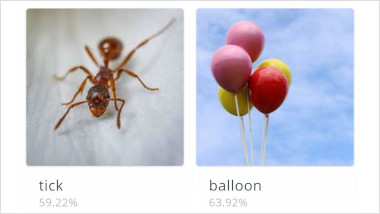

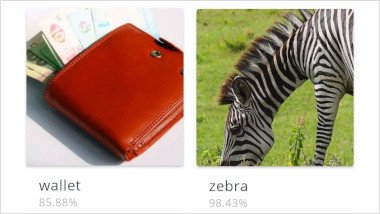

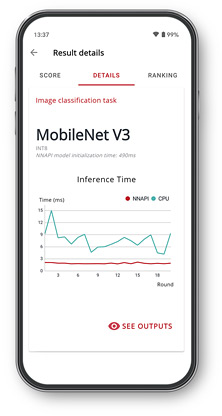

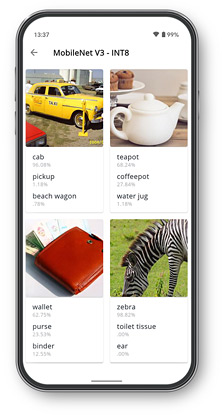

MobileNet V3

MobileNet V3 ist ein kompaktes visuelles Erkennungsmodell, das speziell für mobile Geräte entwickelt wurde. Der Benchmark verwendet MobileNet V3, um das Motiv eines Bildes zu identifizieren, ein Bild als Eingabe zu verwenden und eine Liste von Wahrscheinlichkeiten für den Inhalt des Bildes auszugeben. Der Benchmark verwendet die große minimalistische Variante von MobileNet V3.

Inception V4

Inception V4 ist ein hochmodernes Modell für Bildklassifizierungsaufgaben. Es wurde auf Genauigkeit ausgelegt und ist ein viel breiteres und tieferes Modell als MobileNet. Der Benchmark verwendet Inception V4, um das Motiv eines Bildes zu identifizieren, wobei ein Bild als Eingabe verwendet und eine Liste von Wahrscheinlichkeiten für den im Bild identifizierten Inhalt ausgegeben wird.

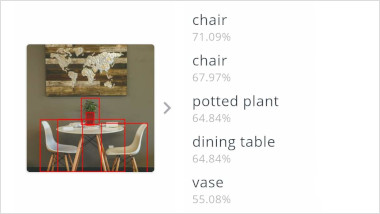

SSDLite MobileNet V3

SSDLite ist ein Objekterkennungsmodell, mit dem Begrenzungsrahmen um Objekte in einem Bild erstellt werden sollen. SSDLite verwendet MobileNet zur Funktionsextraktion, um die Objekterkennung in Echtzeit auf Mobilgeräten zu ermöglichen. Im Benchmark verwendet die Float-Version von SSDLite die kleine minimalistische MobileNet V3-Variante. Die Integer-Version verwendet die Edge-TPU-Variante von MobileNet V3.

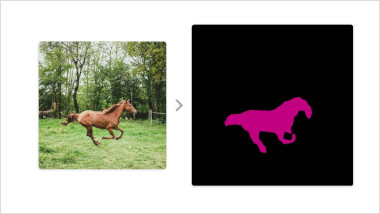

DeepLab V3

DeepLab ist ein Bildsegmentierungsmodell, das darauf abzielt, die Pixel eines Bildes zu gruppieren, die zur gleichen Objektklasse gehören. Die semantische Bildsegmentierung kennzeichnet jeden Bereich des Bildes mit einer Objektklasse. Der Benchmark verwendet MobileNet V2 zur Merkmalsextraktion, um eine schnelle Inferenz mit geringem Qualitätsunterschied im Vergleich zu größeren Modellen zu ermöglichen.

Benutzerdefinierte CNN

Der Benchmark umfasst ein benutzerdefiniertes Convolutional Neural Network (CNN), das auf der AlexNet-Architektur basiert. Es dient zum Testen der Leistung grundlegender CNN-Operationen und wird anhand zufällig generierter Trainingsdaten trainiert. Es enthält zwei Faltungsebenen, gefolgt von Max Pooling- und Dropout-Ebenen, und eine vollständig verbundene Ebene.

Integer und Float Modelle

Der Benchmark umfasst sowohl float- als auch integer-optimierte Versionen jedes Modells. Jedes Modell läuft nacheinander auf der gesamten kompatiblen Hardware des Geräts. Bei NNAPI verwendet der Benchmark die dedizierte AI-Verarbeitungshardware des Geräts, sofern dies unterstützt wird. Float-Modelle verwenden NNAPI oder werden direkt auf der CPU oder GPU ausgeführt. Integer-Modelle verwenden NNAPI oder werden direkt auf der CPU ausgeführt.

Ergebnisse und Erkenntnisse

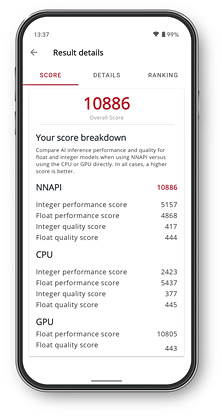

Benchmark-Scores

Testen Sie Geräte und Prozessoren und vergleichen Sie Leistung und Qualität mit Integer- und Float-Modellen.

Leistungsdiagramme

Ein Diagramm für jedes Modell zeigt die Inferenzzeit mit NAPPI und anderen verfügbaren Prozessoren.

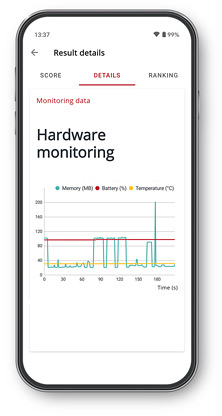

Hardware-Überwachung

Sehen Sie, wie sich Temperatur, Ladezustand des Akkus und Speichernutzung während des Benchmark-Laufs geändert haben.

Modellausgabe

Überprüfen Sie die Ausgabe jedes Modells, um sicherzustellen, dass der Accelerator die richtigen Ergebnisse zurückgibt.

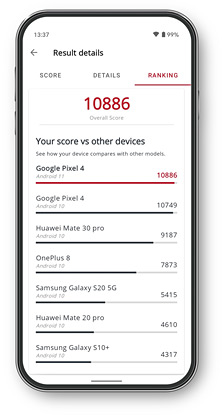

Geräterangliste

Sehen Sie in der Rangliste der In-App-Leistung, wie Ihr Gerät mit anderen Modellen im Vergleich aufgeführt wird.

Kostenlose Testversion

Testversion anfordernSite-Lizenz

Angebot anfragen Presselizenz- Jährliche Standortlizenz für Procyon AI Inference Benchmark für Android.

- Unbegrenzte Anzahl von Benutzern.

- Unbegrenzte Anzahl von Geräten.

- Vorrangiger Support per E-Mail und Telefon

BDP

Kontaktieren Sie uns Mehr erfahrenKontaktieren Sie uns

Das Benchmark Development Program™ ist eine Initiative von UL Solutions zum Ausbau von Partnerschaften mit Technologiefirmen.

OEMs, ODMs, Komponentenhersteller und deren Zulieferer sind eingeladen, gemeinsam mit uns neue Benchmarks für die AI-Verarbeitung zu entwickeln. Bitte kontaktieren Sie uns für Details.

Minimale Systemanforderungen

| Betriebssystem | Android 10 |

|---|---|

| Speicher | 400 MB freier Speicherplatz |

Support

Neueste Version 1.0.56 | 27. Nov. 2020

- Procyon AI Inference Benchmark für Android Benutzerhandbuch

- AI Inference Benchmark für Android Support

Sprachen

- Englisch