Android用のProcyon® AI推論ベンチマーク

NNAPIを用いてAIのパフォーマンスおよび品質をベンチマーク

機械学習は、モバイルアプリの素晴らしい新機能を強化しています。現在、多くのデバイスは、デバイス上での推論に必要な計算集約型の演算を高速化するための専用ハードウェアを搭載しています。Android Neural Networks API (NNAPI) は、機械学習フレームワークがデバイス内の専用AI処理ハードウェアにアクセスするためのベース層を提供します。

ProcyonAI推論ベンチマーク はAndroid用で、NNAPIを使用したAndroidデバイスのAIパフォーマンスを測定します。ベンチマークスコアは、デバイス上での推論演算の速度と精度の両方を反映しています。Android用のProcyonAI推論ベンチマークを使用すると、Androidデバイスの専用AI処理ハードウェアのパフォーマンスを測定できるだけではなく、NNAPIの実装品質も検証できます。

このベンチマークでは、デバイス上で動作する人気の高いさまざまな最先端のニューラルネットワークを使用して、一般的なマシンビジョンタスクを実行します。ベンチマークは、NNAPIを介してデバイスの専用AI処理ハードウェアで実行されます。また、このベンチマークでは、各テストをGPUやCPUで直接実行し、比較します。

機能

- 最先端のニューラルネットワークを用いた一般的なマシンビジョンタスクに基づくテスト。

- 推論パフォーマンスと出力品質の両方を測定。

- NNAPI、CPU、GPUの性能を比較。

- NNAPIの実装と互換性を検証。

- ハードウェアアクセラレータ用のドライバーを最適化。

- 浮動小数点演算と整数演算に最適化されたモデルパフォーマンスの比較。

- デバイス上またはADB経由での簡単な設定と使用手順。

NNAPIのパフォーマンスと品質

Android用のProcyonAI推論ベンチマークを使用すると、専用AI処理ハードウェアのパフォーマンスを測定し、一般的なマシンビジョンタスクに基づくテストでNNAPIの実装品質を検証できます。

プロフェッショナル向けのデザイン

当社は、NNAPI実装と専用モバイルハードウェアの一般的なAIパフォーマンスを評価するために独立した標準化されたツールを必要とするエンジニアリングチーム向けに、Android用のProcyonAI推論ベンチマークを作成しました。

高速で使いやすい

ベンチマークはインストールも実行も簡単で、複雑な設定は一切必要ありません。デバイス上またはADB経由でベンチマークを実行します。ベンチマーク スコア、チャート、ランキングをアプリで表示したり、詳細な結果ファイルをエクスポートしてさらに詳しく分析することができます。

業界の専門知識を活かした開発

Procyonベンチマークは、プロフェッショナルユーザー向けに特別に作成されたテストと機能で、業界、企業、報道機関での使用向けに設計されています。AndroidのAI推論ベンチマークは、ULベンチマーク開発プログラム(BDP)により、業界のパートナーと共に設計および開発されました。BDPは、プログラムメンバーとの密接な連携により、適切かつ公平なベンチマークを作成することを目的としたUL Solutionsのイニシアチブです。

ニューラルネットワークモデル

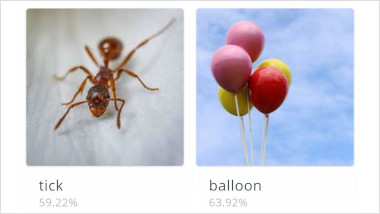

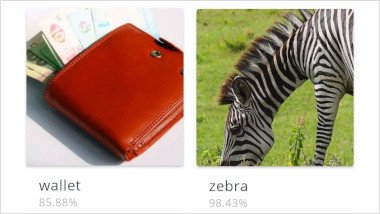

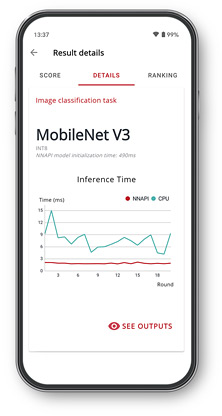

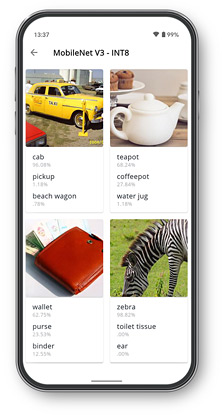

MobileNet V3

MobileNet V3は、モバイルデバイスに特化して作られたコンパクトな視覚認識モデルです。このベンチマークでは、MobileNet V3を用いて画像の被写体を特定します。画像を入力データとして、画像内のコンテンツに対する確率のリストを出力します。このベンチマークでは、MobileNet V3の大規模な軽量バリアントを使用しています。

Inception V4

Inception V4は、画像分類タスクのための最先端モデルです。精度を高めるために設計され、MobileNetよりはるかに広く深いモデルとなっています。このベンチマークでは、Inception V4を用いて画像の被写体を特定します。画像を入力データとして、画像内で特定されたコンテンツに対する確率のリストを出力します。

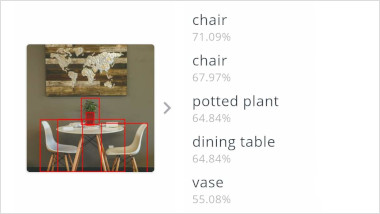

SSDLite MobileNet V3

SSDLiteは、画像中の物体の周囲に境界ボックスを生成することを目的とした物体検出モデルです。SSDLiteは、モバイルデバイスでのリアルタイムな物体検出を可能にするため、機能抽出にMobileNetを使用します。ベンチマークでは、SSDLiteの浮動小数版により、小型の軽量なMobileNet V3バリアントが使用されています。整数版では、MobileNet V3のEdgeTPUバリアントが使用されています。

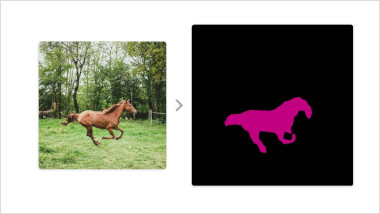

DeepLab V3

DeepLabは、画像中の同じオブジェクトクラスに属する画素をクラスタリングすることを目的とした画像セグメンテーションモデルです。セマンティック画像分割により、画像中の各領域にオブジェクトのクラスをラベル付けします。このベンチマークでは、機能抽出にMobileNet V2を使用することで、大規模なモデルと比較して品質の差が少なく、高速な推論を可能にしています。

カスタムCNN

このベンチマークには、AlexNetアーキテクチャをベースにしたカスタムCNN(Convolutional Neural Network)が含まれています。CNNの基本的な演算のパフォーマンスをテスト向けに設計されており、ランダムに生成された学習データで学習させます。2つの畳み込み層と、それに続く最大値プーリング層とドロップアウト層、そして1つの完全連結層で構成されています。

整数および浮動小数点モデル

このベンチマークには、各モデルの浮動小数点演算および整数演算の最適化版が両方含まれています。該当のデバイスに搭載されたすべての対応ハードウェアで各モデルが順番に実行されます。NNAPIにより、ベンチマークはデバイスの専用AI処理ハードウェアを使用します(サポートされている場合)。整数モデルはNNAPIを使用するか、CPUまたはGPUで直接実行されます。整数モデルはNNAPIを使用するか、CPU上で直接実行されます。

結果とインサイト

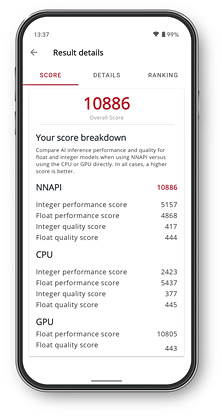

ベンチマーク スコア

デバイスやプロセッサーをテストし、整数モデルと浮動小数点モデルでパフォーマンスと品質を比較します。

パフォーマンス チャート

各モデルのグラフは、NNAPIとその他の利用可能なプロセッサーを使用した推論時間を示しています。

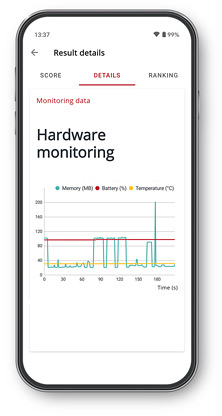

ハードウェア モニタリング

ベンチマーク実行中の温度、バッテリ充電量、メモリ使用量の変化をご覧いただけます。

モデル 出力

各モデルからの出力を確認し、アクセラレータが正しい結果を返していることを確認します。

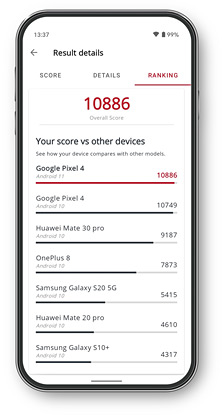

デバイス ランキング

アプリ内のパフォーマンスランキングで他機種との比較を確認することができます。

無償試用

試用リクエストサイトライセンス

見積もり 出版関係者向けライセンス- Android用のProcyonAI推論ベンチマークの年間サイトライセンス。

- ユーザー数、無制限。

- デバイス台数、無制限。

- メールと電話による優先サポート。

最小システム要件

| OS | Android 10 |

|---|---|

| ストレージ | 400MBの空き容量 |